از توصیه محصول گرفته تا وسایل نقلیه خودران تا چت ربات های آنلاین، هوش مصنوعی (AI) به طور فزاینده ای در زندگی روزمره ما رایج می شود. هر بار که با این برنامهها تعامل داریم، از مدلهای شبکه عصبی آموزشدیده در یک فرآیند یادگیری عمیق به نام استنتاج استفاده میکنیم. با توجه به گستره برنامه هایی که ممکن است از استنتاج استفاده کنند، این احتمال وجود دارد که استنتاج بر روی اهداف سخت افزاری مختلف مستقر در ابر، لبه و نقطه پایانی اجرا شود. این ناهمگونی سختافزاری چالشهای نرمافزاری را ایجاد میکند، بهویژه زمانی که توسعهدهندگان اغلب خود را در حال توسعه برنامههای استنتاج بر روی اهداف سختافزاری مختلف با استفاده از پشتههای نرمافزار مستقل میبینند.

موارد استفاده در دنیای واقعی Tencent

با توجه به این چالش نرم افزاری، Tencent اخیراً کیت Tencent Accelerated Computing Optimizer (TACO) خود را منتشر کرده است، سرویس ابری خود برای مشتریان که هدف آن این است که به همه توسعه دهندگان، صرف نظر از سطح تجربه هوش مصنوعی خود، اجازه دهد تا آموزش یادگیری عمیق و استنتاج را با استفاده از انتخاب مدل، چارچوب، و پشتیبان سخت افزاری خود انجام دهند. . در حالی که مشتریان آنها با یک رابط کاربری تمیز و ساده تعامل دارند، کیت TACO Tencent کارهای سنگین را در زیر کاپوت انجام می دهد تا کمک اطمینان حاصل کنید که حجم کاری مشتری به خوبی اجرا می شود. برای استفاده از بهترین عملکرد استنتاج از AMD EPYC™ باطن CPU، Tencent دارای ZenDNN است، کتابخانه استنتاج هوش مصنوعی AMD، به آنها مسیر استنتاج TACO، همچنین به عنوان استنتاج TACO شناخته می شود.

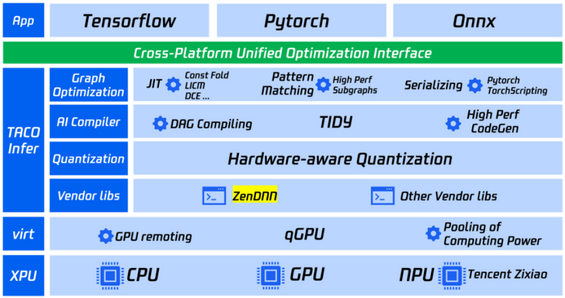

نمودار 1. مروری بر معماری استنتاج TACO Tencent.

نمودار بالا یک نمای کلی از استنتاج TACO Tencent است. قبل از TACO Infer، بار مدیریت چندین هدف سخت افزاری به طور جداگانه برای استقرار استنتاج و تنظیم عملکرد بر دوش کاربران ابری Tencent بود. با توجه به گستردگی انواع مدلهای ظاهری، پشتیبانهای سختافزاری و نسخههای نرمافزاری، کاربران ممکن است خود را تحت تأثیر ترکیبهای مختلف قرار دهند. در دسترس بودن فراوان ابزارهای جامعه به بعد دیگری از پیچیدگی کمک می کند. بهجای ارزیابی مقرونبهصرفهترین و کارآمدترین راهحلها، کاربران به دلیل تلاش و زمان درگیر با کاوش در تغییرات، تمایل به انتخاب گزینههای آشنا دارند. این امر باعث میشود که کاربران ابری برنامههای خود را با مناسبترین نوع محاسبات تطبیق ندهند و پتانسیل رایانش ابری را به طور کامل آزاد کنند.

هدف TACO Infer پرداختن به این مشکل با ارائه کاربران مشتاق به محاسبات سریع با رابط بهینه سازی یکپارچه بین پلتفرمی و دسترسی آسان به قدرت ناهمگن بسیار بهینه شده در Tencent Cloud است. طراحی توسعه پذیر TACO Infer ادغام ZenDNN را به عنوان پشتیبان هسته هنگام هدف قرار دادن AMD EPYC تسهیل می کند. پردازندهدستگاه های مبتنی بر برای سهولت استفاده، TACO Infer به هیچ تغییری در چارچوبهای یادگیری عمیق، مانند TensorFlow یا PyTorch نیاز ندارد. پیوند یک برنامه با کیت توسعه نرم افزار TACO (SDK) برای فعال کردن بهینه سازی ها، از جمله موارد ارائه شده توسط ZenDNN، کافی است. ادغام ZenDNN بیشتر باعث افزایش عملکردی می شود که TACO می تواند به آن دست یابد، همانطور که توسط نقاط داده ای که Tencent در زیر جمع آوری کرده است نشان داده شده است:

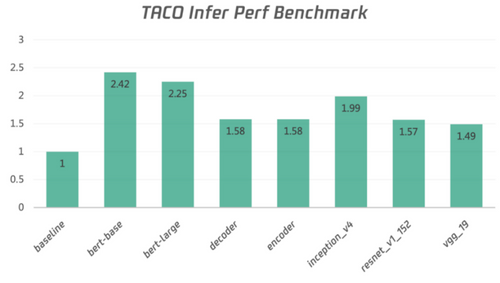

نمودار 2. بهبود عملکرد استنباط با استفاده از ZenDNN در TACO Infer در مقایسه با TensorFlow عمومی، که هر دو بر روی پشتیبانهای CPU AMD EPYC در تست Tencent اجرا میشوند.

نمودار 2 بالا افزایش عملکرد توان عملیاتی را نشان می دهد در تست Tencent به دست آمد با جدیدترین نسخه TACO Infer با استفاده از نمونه SA2 استاندارد Cloud Bare Metal (CBM) Tencent با استفاده از اندازه های دسته ای بهینه شده با تأخیر 1. در انواع مدل های یادگیری عمیق بینایی کامپیوتری و پردازش زبان طبیعی، بهینه سازی ها توسط TACO و ZenDNN به طور مشترک فعال شده اند. بهبود عملکرد استنتاج در مقایسه با خط پایه TensorFlow عمومی.

در پشتیبانی از AMD-Tencent همکاریمدیر بخش سرور ابری Tencent، لیدونگ چن، اظهار داشت: «AMD و Tencent با هم کار می کنند تا کیت Tencent Accelerated Computing Optimizer (TACO) را برای ارائه بهترین تجربه کاربری هوش مصنوعی بهینه کنند. با بهینه سازی TACO با ZenDNN، ما در حال حاضر شاهد افزایش عملکرد امیدوار کننده ای هستیم که در CPU های AMD EPYC اجرا می شود.

شروع کنید!

برای کسب اطلاعات بیشتر در مورد کیت TACO Tencent برای استنباط، به مرکز اسناد TACO Kit Tencent مراجعه کنید.

برای ارزیابی کتابخانه استنتاج ZenDNN AI AMD در پردازنده های AMD EPYC، به صفحه ZenDNN Developer Central مراجعه کنید.